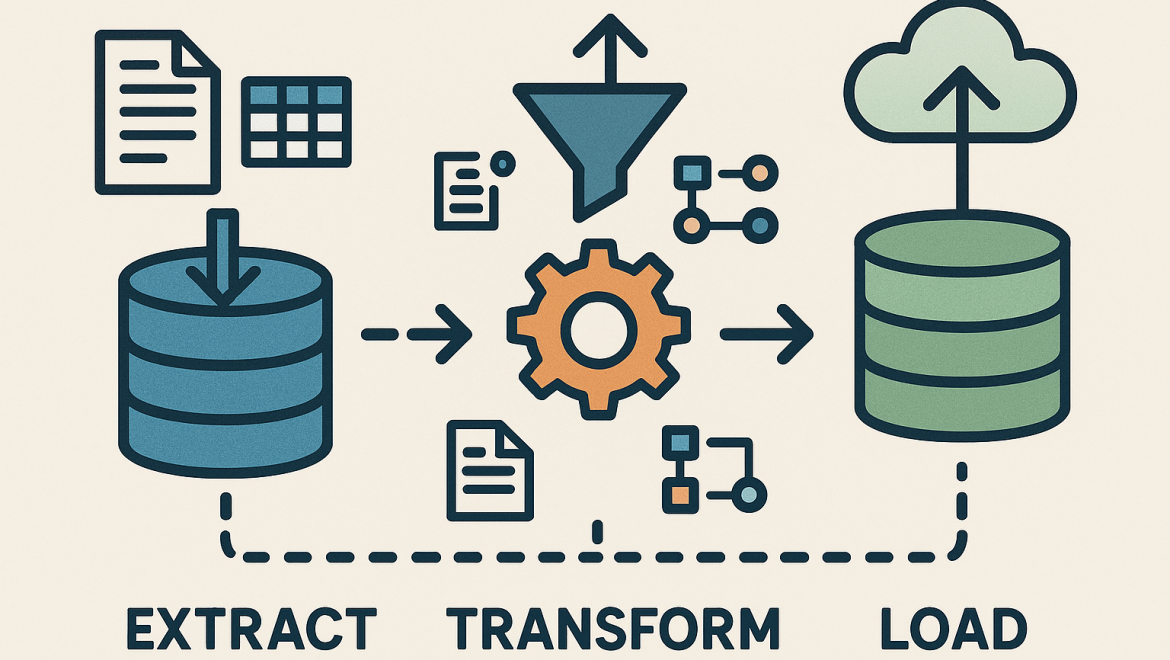

La extracción, transformación y carga de datos (ETL) es un proceso fundamental en la gestión de datos que permite a las organizaciones integrar información de diversas fuentes, transformarla según sus necesidades y cargarla en un sistema de destino para su análisis y explotación1. El diseño eficiente de un sistema ETL es crucial para garantizar la calidad, la eficiencia y la escalabilidad del proceso. En este artículo, exploraremos los patrones, las mejores prácticas y las tendencias actuales en el diseño de ETL.

Patrones de diseño ETL

Existen diversos patrones de diseño que se aplican comúnmente en la construcción de sistemas ETL. Algunos de los más relevantes son:

- ETL por lotes: Este es el patrón más tradicional, donde los datos se extraen, transforman y cargan en lotes a intervalos regulares (horas, días, semanas). Es adecuado para grandes volúmenes de datos y procesos que no requieren inmediatez. Sin embargo, la latencia en la disponibilidad de los datos puede ser un inconveniente en escenarios que demandan información actualizada al instante2.

- ETL en tiempo real: En este patrón, los datos se procesan de forma continua a medida que se generan, lo que permite obtener información actualizada al instante. Es ideal para aplicaciones que requieren análisis en tiempo real, como la detección de fraudes o el monitoreo de sistemas. No obstante, la complejidad de la arquitectura y la necesidad de herramientas especializadas pueden ser desafíos a considerar3.

- ETL basado en eventos: Este patrón se centra en el procesamiento de datos en respuesta a eventos específicos, como la creación de un nuevo registro o la actualización de un campo. Es útil para integrar datos de sistemas que generan eventos en tiempo real, como aplicaciones de comercio electrónico o plataformas de redes sociales. La eficiencia del proceso depende de la capacidad de capturar y procesar los eventos de forma oportuna4.

- ETL incremental: En este patrón, solo se cargan los datos que han cambiado desde la última ejecución del proceso, lo que reduce la cantidad de información a procesar y mejora la eficiencia. Es adecuado para sistemas donde los cambios en los datos son relativamente pequeños, como bases de datos transaccionales. Sin embargo, la identificación precisa de los cambios y la gestión de las actualizaciones pueden requerir mecanismos sofisticados5.

- ETL de flujo de datos: Este patrón se utiliza para procesar grandes volúmenes de datos en movimiento, como los generados por dispositivos IoT o aplicaciones de streaming. Requiere herramientas y arquitecturas especializadas para manejar el flujo continuo de información, como Apache Kafka o Amazon Kinesis. La escalabilidad y la tolerancia a fallos son aspectos críticos en este tipo de sistemas4.

Al elegir un patrón de diseño ETL, es fundamental considerar tres perspectivas clave: 6

- Punto de recuperación: Definir un punto de recuperación en el proceso ETL permite reiniciar el proceso en caso de fallo, minimizando la pérdida de datos y el tiempo de inactividad.

- Optimización de CDC (Change Data Capture): Implementar mecanismos eficientes para capturar los cambios en los datos de origen es crucial para la eficiencia del proceso ETL, especialmente en patrones incrementales o en tiempo real.

- Linaje de datos: Mantener un registro del origen, las transformaciones y el destino de los datos a lo largo del proceso ETL facilita la auditoría, el análisis de impacto y la resolución de problemas.

Además de los patrones mencionados, es importante tener en cuenta los desafíos asociados con el diseño de un framework ETL robusto y escalable7. Algunos de estos desafíos incluyen:

- Manejo de diversas fuentes de datos: Integrar datos de diferentes formatos, estructuras y sistemas puede requerir conectores, transformaciones y estrategias de limpieza específicas.

- Transformaciones complejas: Aplicar reglas de negocio, validaciones y conversiones de datos puede requerir un alto grado de complejidad en el diseño del proceso ETL.

- Requisitos empresariales en evolución: Adaptar el sistema ETL a los cambios en las necesidades del negocio, como la incorporación de nuevas fuentes de datos o la modificación de las reglas de transformación, puede ser un desafío continuo.

Es importante destacar que el proceso ETL no se limita a la carga de datos en almacenes de datos o data lakes8. ETL también se utiliza para integrar datos en sistemas transaccionales, almacenes de datos operacionales, plataformas de inteligencia de negocios y la nube, entre otros.

ETL vs. ELT

En los últimos años, ha surgido un nuevo enfoque para la integración de datos conocido como ELT (Extract, Load, Transform)9. A diferencia de ETL, donde la transformación ocurre antes de la carga, en ELT los datos se cargan primero en el sistema de destino y luego se transforman.

Característica | ETL | ELT |

Transformación | Antes de la carga | Después de la carga |

Complejidad de la etapa de carga | Mayor | Menor |

Flexibilidad en la transformación | Menor | Mayor |

Adecuado para | Datos estructurados y volúmenes moderados | Grandes volúmenes de datos, incluyendo datos no estructurados |

La elección entre ETL y ELT depende de diversos factores, como el volumen y la variedad de los datos, la complejidad de las transformaciones, la capacidad del sistema de destino y los requisitos de tiempo real.

Mejores prácticas en el diseño de ETL

Para asegurar la eficiencia, la mantenibilidad y la escalabilidad de un sistema ETL, es fundamental seguir las mejores prácticas de diseño. Algunas de las más importantes son:

- Diseño modular y reutilizable: Dividir el proceso ETL en módulos independientes y reutilizables facilita el desarrollo, las pruebas y el mantenimiento. Por ejemplo, se pueden crear módulos para la extracción de datos de diferentes fuentes, la limpieza de datos, la aplicación de reglas de negocio y la carga en diferentes destinos10.

- Manejo de errores y registro: Implementar mecanismos robustos para el manejo de errores y el registro de eventos permite identificar y solucionar problemas de forma rápida y eficiente. Esto incluye la captura de errores en cada etapa del proceso, el registro de la información relevante (mensajes de error, timestamps, etc.) y la notificación a los responsables11.

- Monitoreo y ajuste del rendimiento: Monitorear el rendimiento del sistema ETL y realizar ajustes periódicos ayuda a optimizar el proceso y asegurar que cumpla con los requisitos de tiempo y recursos. Esto implica el seguimiento de métricas clave como el tiempo de ejecución, el volumen de datos procesados y el consumo de recursos12.

- Documentación clara y completa: Documentar el diseño, la implementación y la configuración del sistema ETL facilita la comprensión del proceso y la colaboración entre los miembros del equipo. La documentación debe incluir diagramas de flujo de datos, descripciones de las transformaciones, reglas de negocio y detalles de la configuración13.

- Control de versiones: Implementar un sistema de control de versiones para el código y la configuración del ETL permite rastrear los cambios, revertir a versiones anteriores y colaborar de forma eficiente. Herramientas como Git o SVN son ampliamente utilizadas para el control de versiones en proyectos ETL14.

- Calidad y gobernanza de los datos: Integrar controles de calidad de datos en el pipeline ETL es esencial para garantizar la integridad y la confiabilidad de la información. Esto puede incluir la validación de datos, la limpieza de datos, la deduplicación y la aplicación de reglas de negocio15.

- Gestión de metadatos: Documentar y gestionar los metadatos, como el origen de los datos, las transformaciones aplicadas y el esquema de la base de datos de destino, facilita la comprensión del proceso ETL, el análisis de impacto y la resolución de problemas7.

- Flujo de datos y flujo de control: Definir claramente el flujo de datos y el flujo de control en el pipeline ETL es crucial para garantizar el procesamiento ordenado de las tareas. El flujo de control define las dependencias entre las tareas y asegura que se ejecuten en el orden correcto16.

- Registro de auditoría: Registrar información detallada sobre cada paso del proceso ETL, incluyendo quién realizó la acción, cuándo se realizó y qué datos se modificaron, es fundamental para la auditoría, el análisis de rendimiento y el seguimiento del linaje de datos17.

ETL Testing

Las pruebas son una parte integral del desarrollo de cualquier sistema ETL. Realizar pruebas exhaustivas en diferentes etapas del proceso ayuda a garantizar la calidad de los datos, la confiabilidad del pipeline y el cumplimiento de los requisitos empresariales18. Algunos tipos comunes de pruebas ETL son:

- Pruebas unitarias: Se centran en probar módulos individuales del pipeline ETL, como transformaciones o funciones de limpieza de datos, de forma aislada.

- Pruebas de integración: Verifican la interacción entre diferentes módulos del pipeline ETL, asegurando que los datos fluyan correctamente entre las etapas.

- Pruebas del sistema: Prueban el sistema ETL completo de extremo a extremo, incluyendo la extracción de datos de las fuentes, la transformación y la carga en el destino.

Tendencias actuales en ETL

El campo de ETL está en constante evolución, impulsado por las nuevas tecnologías y las demandas del mercado. Algunas de las tendencias más relevantes son:

- ETL sin código o de bajo código: Estas herramientas permiten a los usuarios crear procesos ETL con una mínima o nula programación, lo que facilita la adopción y reduce la necesidad de conocimientos técnicos especializados. Plataformas como Zapier o Tray.io ofrecen interfaces visuales e intuitivas para la integración de datos. Esta tendencia democratiza el acceso a ETL, permitiendo a usuarios no técnicos construir pipelines de datos. Sin embargo, la flexibilidad y la capacidad de personalización pueden ser limitadas en comparación con las herramientas tradicionales19.

- ETL en la nube: Las soluciones ETL en la nube ofrecen escalabilidad, flexibilidad y rentabilidad, al aprovechar la infraestructura y los servicios de proveedores como AWS, Azure o Google Cloud. Servicios como AWS Glue, Azure Data Factory o Google Cloud Dataflow permiten procesar grandes volúmenes de datos sin la necesidad de invertir en infraestructura local. La adopción de ETL en la nube está en auge, impulsada por la creciente popularidad de los data lakes y los almacenes de datos en la nube. Sin embargo, la seguridad de los datos, la latencia y la dependencia del proveedor son aspectos a considerar20.

- ETL basado en inteligencia artificial: La inteligencia artificial se está utilizando para automatizar y optimizar diferentes aspectos del proceso ETL, como la detección de errores, la transformación de datos y el ajuste del rendimiento. Algoritmos de machine learning pueden identificar patrones en los datos, predecir errores y optimizar las transformaciones. Esta tendencia promete mejorar la eficiencia y la precisión del ETL, pero la interpretabilidad de los modelos y la gestión de los sesgos son desafíos a abordar4.

- Integración de datos en tiempo real: La demanda de información en tiempo real está impulsando la adopción de soluciones ETL que permiten procesar datos de forma continua y obtener insights al instante. Tecnologías como Apache Kafka o Amazon Kinesis permiten capturar y procesar flujos de datos en tiempo real. Esta tendencia es crucial para aplicaciones como el análisis de redes sociales, la detección de fraudes y el monitoreo de sistemas. Sin embargo, la complejidad de la arquitectura y la necesidad de herramientas especializadas pueden ser barreras de entrada21.

- DataOps: Esta metodología busca aplicar los principios de DevOps al campo de la gestión de datos, fomentando la colaboración, la automatización y la mejora continua en el ciclo de vida de los datos. DataOps promueve la integración entre los equipos de desarrollo, operaciones y análisis de datos, con el objetivo de acelerar la entrega de valor a partir de los datos. Esta tendencia está ganando terreno a medida que las organizaciones buscan mejorar la agilidad y la eficiencia en la gestión de datos. Sin embargo, la adopción de DataOps requiere un cambio cultural y la implementación de nuevas herramientas y procesos22.

Estas tendencias reflejan los “vientos de cambio” en el entorno analítico, donde la integración de datos se está volviendo más ágil, automatizada y orientada a la nube23.

Casos de uso de ETL en diferentes industrias

ETL se utiliza en una amplia variedad de industrias para integrar, transformar y analizar datos. Algunos ejemplos son:

Industry | Use Cases | Benefits |

Retail | Integrar datos de ventas, inventario, clientes y marketing para analizar el comportamiento del consumidor, optimizar las campañas de marketing y mejorar la gestión de la cadena de suministro. | Mejorar la segmentación de clientes, personalizar las ofertas, optimizar los precios y predecir la demanda. |

Finanzas | Integrar datos de transacciones, riesgos, clientes y mercados para detectar fraudes, gestionar carteras de inversión y cumplir con las regulaciones. | Prevenir el fraude, evaluar el riesgo crediticio, optimizar las inversiones y cumplir con las normativas. |

Salud | Integrar datos de pacientes, historiales clínicos, tratamientos y resultados para mejorar la atención médica, la investigación y la gestión hospitalaria. | Personalizar los tratamientos, mejorar la eficiencia operativa, acelerar la investigación médica y optimizar la gestión de recursos. |

Manufactura | Integrar datos de producción, inventario, calidad y logística para optimizar la eficiencia operativa, reducir costos y mejorar la calidad del producto. | Optimizar la producción, predecir fallos en los equipos, mejorar la gestión de la cadena de suministro y controlar la calidad del producto. |

Herramientas y tecnologías populares para ETL

Existen numerosas herramientas y tecnologías disponibles para el desarrollo de sistemas ETL. Estas herramientas ofrecen una serie de beneficios, como la mejora de la calidad de los datos, la consistencia y la velocidad del proceso26. Se pueden clasificar en tres categorías principales: 27

- Comerciales: Ofrecen funcionalidades avanzadas, soporte técnico y una amplia gama de conectores. Ejemplos: Informatica PowerCenter, IBM Infosphere Information Server, Oracle Data Integrator.

- Código abierto: Son gratuitas, flexibles y cuentan con una gran comunidad de usuarios. Ejemplos: Talend Open Studio, Apache Kafka, Apache Nifi.

- Personalizadas: Se desarrollan a medida para satisfacer las necesidades específicas de una organización. Ofrecen un alto grado de control pero requieren un mayor esfuerzo de desarrollo y mantenimiento.

Al elegir una herramienta ETL para Big Data, es crucial considerar factores como el volumen de datos, la velocidad de los datos, la variedad de los datos y los requisitos de escalabilidad28.

Herramienta | Descripción | Tipo |

Informatica PowerCenter | Herramienta ETL completa con una amplia gama de conectores y funcionalidades. Permite la integración de datos de diversas fuentes, la transformación de datos mediante una interfaz gráfica o código y la carga en diferentes destinos. | Comercial |

Azure Data Factory | Servicio de ETL en la nube de Microsoft Azure. Ofrece una interfaz visual para la creación de pipelines de datos, la integración con otros servicios de Azure y la escalabilidad en la nube. | Comercial |

AWS Glue | Servicio de ETL sin servidor de Amazon Web Services. Permite procesar datos de diferentes fuentes, aplicar transformaciones y cargarlos en data lakes o almacenes de datos en la nube. | Comercial |

Talend Open Studio | Herramienta ETL de código abierto con una interfaz gráfica y una amplia comunidad. Ofrece una variedad de componentes para la extracción, transformación y carga de datos, así como conectores para diferentes bases de datos y aplicaciones. | Código abierto |

Apache Kafka | Plataforma de streaming de datos de código abierto. Permite la captura, el procesamiento y el almacenamiento de flujos de datos en tiempo real. Se utiliza en una variedad de casos de uso, como la integración de datos en tiempo real, el análisis de eventos y el procesamiento de mensajes. | Código abierto |

Apache Nifi | Herramienta de código abierto para la automatización del flujo de datos. Permite la creación de pipelines de datos complejos mediante una interfaz gráfica de arrastrar y soltar. Ofrece una amplia gama de procesadores para la transformación, el enrutamiento y el procesamiento de datos. | Código abierto |

Conclusiones

El diseño de un sistema ETL eficiente es crucial para el éxito de cualquier iniciativa de gestión de datos. La elección de los patrones de diseño, la aplicación de las mejores prácticas y la adopción de las últimas tendencias permiten a las organizaciones construir sistemas ETL robustos, escalables y adaptados a sus necesidades. La selección de las herramientas y tecnologías adecuadas también juega un papel fundamental en la eficiencia y la efectividad del proceso ETL.

En el mundo actual, donde el volumen y la complejidad de los datos están en constante crecimiento, ETL se ha convertido en una herramienta esencial para las organizaciones que buscan obtener valor de sus datos. Los patrones de diseño ETL, como el procesamiento por lotes, en tiempo real, basado en eventos e incremental, ofrecen diferentes enfoques para la integración de datos, cada uno con sus propias ventajas y desventajas. La aplicación de las mejores prácticas, como el diseño modular, el manejo de errores, el monitoreo del rendimiento y el control de versiones, es fundamental para garantizar la calidad, la eficiencia y la mantenibilidad del sistema ETL.

Las tendencias actuales en ETL, como la adopción de soluciones sin código o de bajo código, la migración a la nube, la integración de la inteligencia artificial y la creciente demanda de integración de datos en tiempo real, están transformando el panorama de la gestión de datos. Estas tendencias ofrecen nuevas oportunidades para la automatización, la escalabilidad y la agilidad en el proceso ETL.

La elección de las herramientas y tecnologías adecuadas para ETL depende de las necesidades específicas de cada organización, incluyendo el volumen y la variedad de los datos, la complejidad de las transformaciones y los requisitos de tiempo real. Existen numerosas herramientas disponibles, tanto comerciales como de código abierto, que ofrecen una amplia gama de funcionalidades y capacidades.

En última instancia, el éxito de un proyecto ETL depende de la capacidad de la organización para integrar los datos de forma eficiente, transformarlos según sus necesidades y cargarlos en un sistema de destino que permita el análisis y la toma de decisiones informadas.

Works cited

- What is ETL (Extract, Transform, Load)? A Full Breakdown – ThoughtSpot, accessed January 7, 2025, https://www.thoughtspot.com/data-trends/data-integration/what-is-etl

- ETL en tiempo real vs. ETL por lotes: ¿cuál elegir? – Vailos, accessed January 7, 2025, https://www.vailos.com/etl-tiempo-real-etl-por-lotes-mejor-opcion/

- www.vailos.com, accessed January 7, 2025, https://www.vailos.com/etl-tiempo-real-etl-por-lotes-mejor-opcion/#:~:text=Qu%C3%A9%20es%20ETL%20en%20tiempo,se%20transfieren%20en%20tiempo%20real.

- ¿Qué es extracción, transformación y carga (ETL)? – AWS, accessed January 7, 2025, https://aws.amazon.com/es/what-is/etl/

- ETL Incremental Loading 101: A Comprehensive Guide – Hevo Data, accessed January 7, 2025, https://hevodata.com/learn/etl-incremental/

- 3 perspectivas a tener en cuenta en el diseño de procesos ETL – Blog, accessed January 7, 2025, https://blog.es.logicalis.com/analytics/3-perspectivas-a-tener-en-cuenta-en-el-dise%C3%B1o-de-procesos-etl

- Arquitecturas ETL escalables: manejo de grandes volúmenes de datos – Astera Software, accessed January 7, 2025, https://www.astera.com/es/knowledge-center/scalable-etl-architectures/

- What Is ETL? – SAS Institute, accessed January 7, 2025, https://www.sas.com/es_co/insights/data-management/what-is-etl.html

- ¿ETL o ELT? Diferencias y casos de uso – Blog de Bismart, accessed January 7, 2025, https://blog.bismart.com/etl-o-elt-diferencias-y-casos-de-uso

- ETL Modularity – Tim Mitchell, accessed January 7, 2025, https://www.timmitchell.net/post/2016/07/11/etl-modularity/

- Control de errores en los datos – SQL Server Integration Services (SSIS) – Microsoft Learn, accessed January 7, 2025, https://learn.microsoft.com/es-es/sql/integration-services/data-flow/error-handling-in-data?view=sql-server-ver16

- Sugerencias de ajuste de rendimiento – IBM, accessed January 7, 2025, https://www.ibm.com/docs/es/tap/4.5?topic=spoon-performance-tuning-tips

- Claves para documentar los procesos ETL – Gestión de Datos, accessed January 7, 2025, https://blog.powerdata.es/el-valor-de-la-gestion-de-datos/bid/405810/claves-para-documentar-los-procesos-etl

- ETL Version Control why you need it, accessed January 7, 2025, https://www.etl-tools.com/articles/etl-version-control-why-you-need-it.html

- Data Integration. Las mejores prácticas para integrar datos de diferentes fuentes, accessed January 7, 2025, https://dataspurs.com/blog/data-integration-las-mejores-practicas-para-integrar-datos-de-diferentes-fuentes/

- Extraer, transformar, cargar (ETL) – Azure Architecture Center – Microsoft Learn, accessed January 7, 2025, https://learn.microsoft.com/es-es/azure/architecture/data-guide/relational-data/etl

- Ejemplo de Procesos ETL en Calidad de Datos – Lituus Analytics, accessed January 7, 2025, https://lituus.cl/Analytics/business-intelligence/ejemplo-de-procesos-etl-en-calidad-de-datos.html

- Pruebas ETL: procesos, tipos y mejores prácticas – Astera Software, accessed January 7, 2025, https://www.astera.com/es/type/blog/etl-testing/

- 15 mejores herramientas ETL en 2024 – Astera Software, accessed January 7, 2025, https://www.astera.com/es/knowledge-center/what-is-etl-tool/

- ¿Qué es ETL? – Google Cloud, accessed January 7, 2025, https://cloud.google.com/learn/what-is-etl?hl=es

- ¿Qué es la integración de datos? – Google Cloud, accessed January 7, 2025, https://cloud.google.com/learn/what-is-data-integration?hl=es-419

- datakitchen.io, accessed January 7, 2025, https://datakitchen.io/what-is-dataops/#:~:text=DataOps%20is%20a%20collection%20of,to%20customers%20with%20increasing%20velocity

- Vientos de cambio en el entorno analítico, de ETL a ELT, accessed January 7, 2025, https://itblogsogeti.com/2020/04/15/vientos-de-cambio-en-el-entorno-analitico-de-etl-a-elt/

- Herramientas ETL: las tendencias de la industria y demanda creciente – TCIT, accessed January 7, 2025, https://www.tcit.cl/herramientas-etl-las-tendencias-de-la-industria-y-demanda-creciente/

- Lista de las 19 mejores herramientas ETL y por qué elegirlas – DataCamp, accessed January 7, 2025, https://www.datacamp.com/es/blog/a-list-of-the-16-best-etl-tools-and-why-to-choose-them

- Las 10 mejores herramientas ETL (enero de 2025) – Unite.AI, accessed January 7, 2025, https://www.unite.ai/es/mejores-herramientas-etl/

- Procesos ETL: transformando datos en información – blog incentro, accessed January 7, 2025, https://www.incentro.com/es-ES/blog/proceso-etl

- Cuales son las herramientas ETL más usadas? – Modus Management, accessed January 7, 2025, https://www.modus.es/herramientas-etl-mas-usadas/

- Las 16 Mejores Herramientas ETL para 2024 – Conecta Magazine, accessed January 7, 2025, https://www.conectasoftware.com/magazine/las-16-mejores-herramientas-etl-para-2023/